Introduzione

Nei Corsi di Laurea di Infermieristica e di Infermieristica Pediatrica, diversamente da altri percorsi formativi universitari professionalizzanti, l’abilitazione professionale è contestuale al conseguimento del titolo di studio (art. 4 della legge 573/1996).

L’esame di abilitazione finale, ai sensi della normativa vigente, si compone di una prova pratica e dalla redazione e dissertazione di un elaborato di tesi.[1]

L’obiettivo dell’esame di abilitazione è di valutare e certificare il raggiungimento delle competenze attese da un laureando, nel quadro dei learning outcome rappresentati dai Descrittori di Dublino, nello specifico: la conoscenza e la capacità di comprensione teoriche ed applicate; l'autonomia di giudizio, le abilità comunicative e la capacità di apprendere.[2]

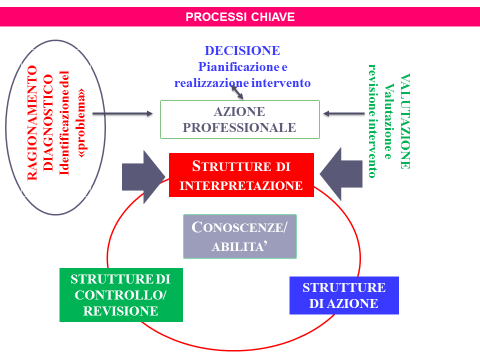

La prova pratica deve essere in grado di fare emergere tre capacità, che contraddistinguono il professionista da un semplice erogatore di prestazioni tecniche: la capacità di ragionamento diagnostico, correlata alla struttura di interpretazione della situazione; la capacità decisionale, che richiama le strutture e i meccanismi che sostengono l’azione; la capacità valutativa, che richiama le strutture di controllo e revisione dell’azione (Schema 1).[3][4]

Schema 1: processi chiave nell’esercizio della competenza

A tale proposito, sia la Conferenza Permanente delle Classi di Laurea delle Professioni Sanitarie, sia la Federazione Nazionale dei Collegi IPASVI hanno stilato specifici documenti nei quali viene riaffermata la necessità e l’importanza di progettare e realizzare una prova che consenta di: valutare la componente intellettiva, affrontare situazioni prossime alla vita professionale, ridurre possibili ambiguità valutative e agevolare i suoi tempi di realizzo e correzione. Tale esigenza è nata anche dalla constatazione che ad oggi le modalità d’esame e le tipologie di prove, nei diversi corsi, sono state alquanto disomogenee tra loro, rendendo difficoltosa qualsiasi forma di confronto.

Alla luce di quanto premesso, il Coordinamento Regionale dei Collegi IPASVI del Piemonte, con il Collegio IPASVI di Aosta, e il Coordinamento dei Corsi di Laurea delle tre Università che insistono sul territorio piemontese e Valle d’ Aosta (Università di Torino, Piemonte Orientale “A. Avogadro”, Università Cattolica del Sacro Cuore), hanno convenuto di procedere a un’iniziativa congiunta per rendere operative tali linee guida, armonizzandone rendendo uguali sul piano metodologico, tale esame. Operativamente l'iniziativa si è concretizzata in un progetto con l’obiettivo di predisporre e sperimentare una sorta di “banca dati” da cui attingere le micro-situazioni assistenziali per formulare la prova pratica d’esame in sede locale. In particolare è stata condivisa l’opportunità di predisporre un nuovo tipo di prova destinato a valutare specificamente le competenze intellettive del laureando, nella fattispecie le sue capacità di ragionamento diagnostico, decisionali e valutative, attraverso dei micro-casi a risposta multipla.

Tale decisione è stata sostenuta da alcune motivazioni: un’interpretazione estensiva del concetto di pratica che, essendo riferita a un professionista intellettuale, non può essere ricondotta al piano puramente gestuale; il fatto che le abilità gestuali (certificate sul libretto delle attività tecniche) dello studente sono abbondantemente valutate nel triennio durante i tirocini, il fatto che qualsiasi prova simulata per valutare le capacità gestuali e soprattutto relazionali-comunicative, al di fuori dei contesti assistenziali reali, si presta a forzature e ad artificiosità poco attendibili oltre che diseconomiche e infine, l’esigenza di uniformare e omogenizzare le prove d’esame al fine di poter consentire un successivo confronto dei risultati didattici e professionali conseguiti tra le diverse sedi di studio.[5][6][7]

Metodi e strumenti

Il metodo, coerentemente con quanto descritto nella vasta letteratura in merito alle prove strutturate, ha previsto la formulazione di circoscritte e contestualizzate micro situazioni/item, in sei aree clinico assistenziali fondamentali dal punto di vista clinico-assistenziale per un futuro esercizio professionale, correlati ai problemi prioritari di salute (area criticità vitale; problemi cardiorespiratori cronici; problemi oncoematologici; problemi metabolici cronici; problemi gastrointestinali; problemi neurologici cronici; intervento chirurgico) e quattro aree trasversali (sicurezza cure e ambiente; organizzazione dell’assistenza; responsabilità professionale).

Ciascuna micro-situazione propone al candidato un problema da comprendere e da affrontare con decisioni professionali o da valutare. Tale impostazione metodologica si fonda sul passaggio da un sapere autoreferenziale, centrato sulla conoscenza, a un impiego dei propri saperi per affrontare situazioni prossime alla vita reale, integrando le conoscenze acquisite durante il percorso di studi.[8][9][10]

Tecnicamente, per ogni micro situazione proposta è stato definito un preciso quesito, detto stimolo, a cui fare corrispondere quattro opzioni di risposta, di cui una sola corretta. Le risposte possibili, a eccezione di quella corretta, vengono chiamate distrattori, in quanto sono risposte apparentemente plausibili, la cui funzione è quella di distrarre dalla risposta corretta, cosicché, questa, sia frutto di un processo di discriminazione.

Una prova ben fatta deve contenere item di diverso livello di difficoltà e capaci di distinguere i soggetti che rispondono complessivamente bene alla prova dai soggetti che invece non lo fanno.

La fase di costruzione e sperimentazione dei micro-casi è avvenuta in tre edizioni distinte, ognuna caratterizzata dalla: costruzione degli item, con cinque risposte, di cui una eliminata, poiché poco distraente, dopo l’analisi statistica; valutazione della loro qualità metodologica in termini di presenza dei requisiti strutturali e dalla relativa sperimentazione presso gli studenti del corso per la loro validazione statistica. Ogni edizione è stata preceduta da un corso di formazione accreditato ECM durante il quale sono state fornite le informazioni sul metodo ed è stata condotta una prima esercitazione supervisionata. In tutte e tre le edizioni il lavoro di produzione supervisionata degli item ha avuto la durata di circa un mese.

I gruppi di lavoro hanno coinvolto complessivamente 198 infermieri tra tutor clinici delle sedi di tirocinio e tutor pedagogici con la funzione di coordinatori dei singoli piccoli gruppi scelti anche in considerazione del loro ruolo di docenti presso il corso di laurea nelle discipline infermieristiche.

Per la validazione degli item sono stati utilizzati i seguenti indici: di difficoltà (ID), di discriminatività (IDis), di distrattività, coefficiente di affidabilità (Alfa di Cronbach o coerenza interna) e coefficiente di relazione o punto biseriale. Per la loro applicazione ci si è avvalsi della consulenza di un docimologo.

Per confermare la pertinenza, l’adeguatezza e la coerenza con le più aggiornate evidenze scientifiche dei contenuti descritti nelle singole micro situazioni, gli item sono poi stati sottoposti alla verifica di una comunità allargata di esperti clinici (medici e infermieri) individuati all’interno dei diversi contesti lavorativi.

Risultati e discussione

In un periodo compreso tra il luglio 2014 e il giugno 2015, sono stati sottoposti a test di validazione, attraverso 3 distinte edizioni, complessivamente 463 item e sono stati coinvolti complessivamente 1777 studenti del terzo anno provenienti dalle 14 sedi di corso piemontesi (Tabella 1).

|

Tabella 1 – distribuzione domande e campione studenti coinvolto |

||||

|

Edizione |

Item n. |

Gruppi n. |

Totale item n. |

Studenti n. |

|

1° |

30 |

5 |

150 |

469 |

|

2° |

45 |

2 |

90 |

409 |

|

3° |

40 |

5 |

223 |

899 |

|

|

|

|

463 |

1777 |

La prima selezione degli item è stata fatta in relazione all’indice di difficoltà: sono stati inclusi tutti gli item con difficoltà compresa tra lo 0,25 e lo 0,75 (25% e 75%), e, di conseguenza, esclusi quelli con valori ≥ 0,75 e ≤ 0,25.

I rimanenti sono stati selezionati per indice di discriminatività che ha portato a escludere tutti gli item con un valore ≥ 10.

In una terza fase è stato preso in considerazione il coefficiente di coerenza interna Alfa di Cronbach, includendo tutti gli item con valori ≥ 0,60.

Terminata la selezione degli item si è provveduto per ciascuno di essi a eliminare una delle 5 risposte proposte al candidato, scegliendo quella risultata meno distraente.

In totale sono stati eliminati 115 item (Tabella 2).

|

Tabella 2 – criteri di esclusione item (n, %) |

||

|

n |

% |

Criterio |

|

52 |

11 |

ID 0,013 e 0,19 (item troppo facile) |

|

53 |

11,5 |

ID 0,75 e 0,99 (item troppo difficile) |

|

10 |

O,6 |

IDis ≤ 10 (min – 0,03 –max 0,09) (item poco discriminanti) |

Sono stati invece validati 338 Item raggruppati in relazione all’ambito affrontato come riassunto nella tabella sottostante (Tabella 3).

|

Tabella 3 – distribuzione n (%) degli item nell’ambito clinico assistenziale |

|||||

|

Acronimo |

Ambito clinico assistenziale |

n |

% |

||

|

C.V. |

Criticità Vitale |

37 |

10 |

||

|

C.R. |

Problemi Cardiorespiratori |

49 |

15 |

||

|

O.E. |

Problemi Oncoematologici |

26 |

7,5 |

||

|

M.C. |

Metabolici Cronici |

32 |

7,5 |

||

|

G.I. |

Problemi Gastrointestinali |

27 |

7,5 |

||

|

N.C. |

Neurologici Cronici |

33 |

7,5 |

||

|

I.C. |

Intervento Chirurgico |

53 |

12,5 |

||

|

S.C.A. |

Sicurezza Cure e ambiente |

23 |

10 |

||

|

O.A. |

Organizzazione dell'assistenza |

18 |

7,5 |

||

|

R.P. |

Responsabilità professionale |

40 |

15 |

||

|

|

338 |

100 |

|||

La media calcolata degli indici di difficoltà degli item sperimentati è riassunta nella seguente tabella (Tabella 4).

|

Tabella 4 – media indice di difficoltà (n, %) |

||

|

Edizione |

n |

% |

|

1 |

0,43 |

43 |

|

2 |

0,37 |

37 |

|

3 |

0,45 |

45 |

Le prove sperimentate rientrano in una fascia che dalla letteratura viene definita a facilità media. Per quanto riguarda il coefficiente di coerenza interna, Alfa di Cronbach i valori ottenuti sono stati tutti al di sopra di 0,77; il che evidenzia, secondo la letteratura, una buona coerenza interna.

Non si sono osservate differenze di distribuzione nel numero di item eliminati per ogni ambito clinico. Il tempo medio per rispondere a ogni singolo item è stato di un minuto.

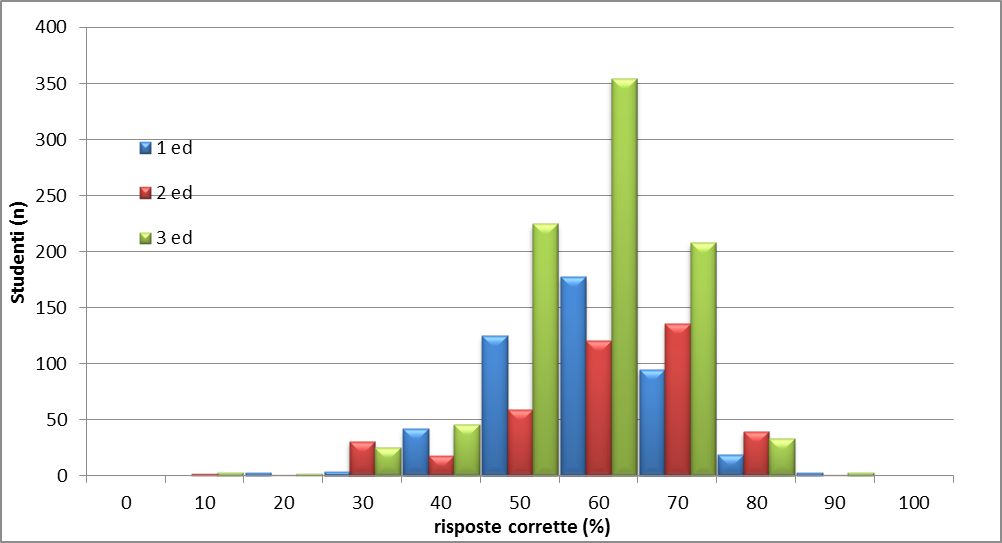

Dalla distribuzione riportata nel grafico sottostante (Grafico 1) si può osservare che all’interno della curva gaussiana si collocano gli studenti (76,2%) che hanno risposto correttamente a una percentuale di domande compresa tra il 50 % e il 70%.

Grafico 1: distribuzione complessiva

Nelle code sono collocati tutti quegli studenti che hanno risposto correttamente a una percentuale minima pari al 10% degli item e una percentuale massima pari al 80% degli item proposti; 7 studenti hanno risposto al 90% degli item.

Dal punto di vista docimologico, la prova è da considerare valida (valore medio indice di discriminatività ≥ 0,25) in quanto è in grado di sollecitare prestazioni direttamente connesse agli obiettivi di apprendimento e in quanto favorisce la manifestazione proprio di quelle competenze che effettivamente si vogliono rilevare. I quesiti rappresentano un’adeguata campionatura delle competenze relative a uno o più ambiti disciplinari e a un livello di difficoltà accettabile (media della difficoltà degli item 0,42).

La prova è anche da considerare attendibile poiché le informazioni che si ottengono non sono ambigue, non interpretabili e possono essere rilevate in modo uniforme da diversi osservatori e per campioni di studenti diversi. Le curve di distribuzione nelle tre edizioni sono sovrapponibili e, considerando che le edizioni hanno coinvolto campioni diversi di studenti, provenienti da Corsi di Laurea differenti, questa distribuzione, seppur in via indiretta, ci fornisce un’informazione di rimando, che merita ulteriori riflessioni, sui programmi di studio, pressoché convergenti in tutte le sedi.

Conclusioni

Un sistema di valutazione così strutturato deve necessariamente tenere conto di un’eventuale futura revisione e riprogettazione del sistema di valutazione all’interno delle sedi, pensando di sottoporre agli studenti prove di questo tipo anche durante le normali sessioni d’esame, non solo per addestrare lo studente, ma anche per valutare in modo più sistematico le competenze intellettive, che, come affermato precedentemente, sono il core dell’azione professionale. Il numero di item prodotto non è ancora sufficiente per consentire un’ampia possibilità di scelta da parte delle commissioni esaminatrici e, pertanto, il lavoro proseguirà con le stesse modalità adottate in questa esperienza anche nel 2016. Nel frattempo è possibile incominciare ad adottare tale sistema di valutazione in occasione delle prossime sessioni d'esame di stato, al fine di avviare un’analisi tra i diversi risultati emersi tra le sedi di corso.